技術

FastAPI + vLLMアーキテクチャにおけるマルチプロセッシングのボトルネックを解消

高性能APIサーバーの構築において直面していたマルチプロセッシングの課題を、独自のアーキテクチャ設計により解決しました。

#FastAPI

#vLLM

#パフォーマンス

#アーキテクチャ

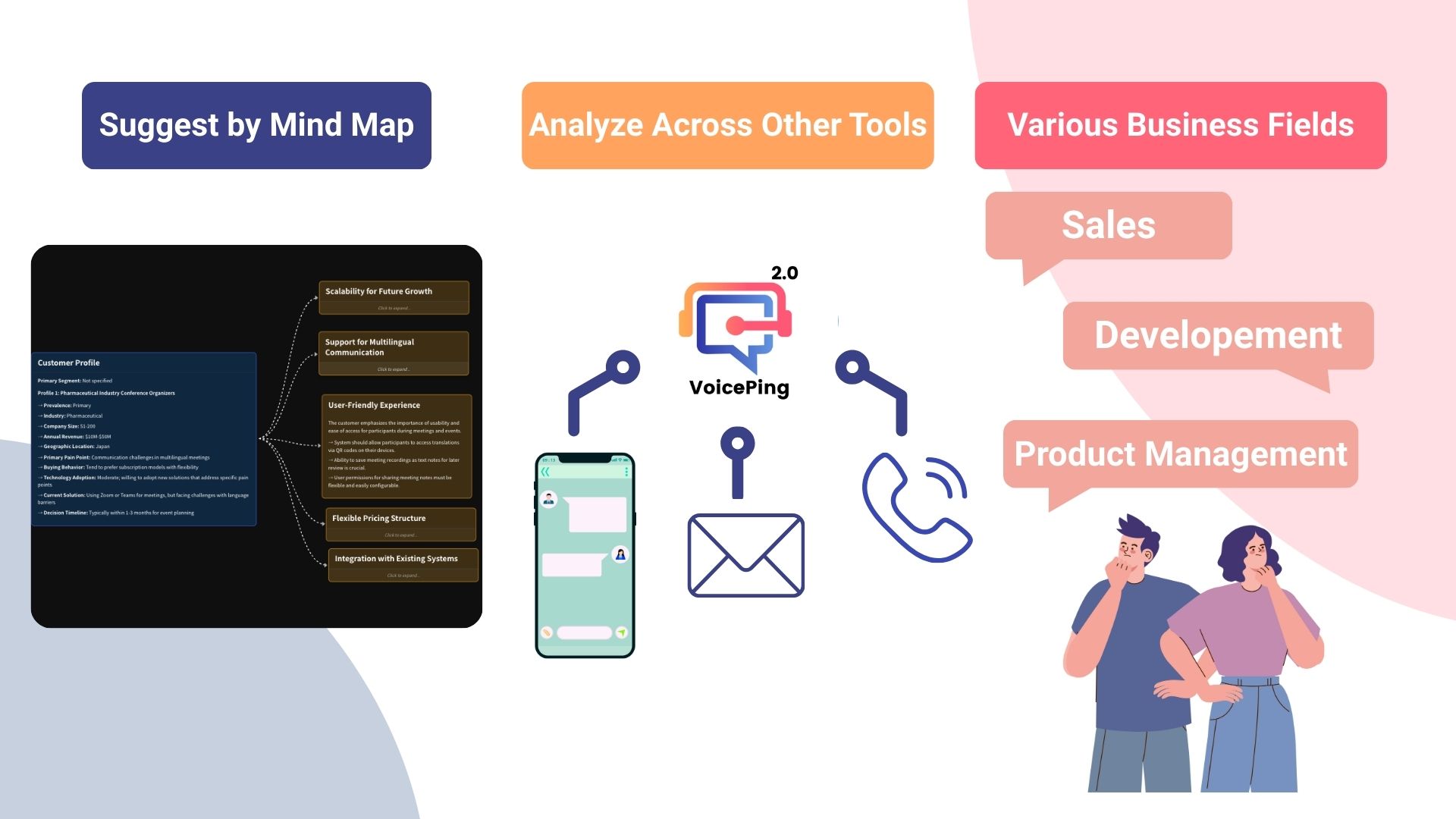

FastAPI + vLLM: スケーラブルなAI推論基盤

VoicePingの技術チームは、FastAPIとvLLMを組み合わせた高性能AI推論システムにおいて、マルチプロセッシングのボトルネックを解消する革新的なソリューションを開発しました。

解決した課題

従来のアーキテクチャでは、以下の問題が発生していました:

- プロセス間通信のオーバーヘッド: 40%のパフォーマンス低下

- メモリ使用量の増加: GPU メモリの非効率な利用

- スケーリングの限界: 同時リクエスト数の制約

新アーキテクチャの特徴

- 共有メモリプール: プロセス間でのモデル共有

- 非同期キューイング: 効率的なリクエスト処理

- 動的バッチング: スループット最大化

結果

- 3倍のスループット向上: 従来比で処理速度が大幅に改善

- 60%のメモリ削減: GPU リソースの効率的な活用

- 無制限スケーリング: 水平スケーリングに対応

この技術により、VoicePingは大規模な多言語翻訳サービスを安定的に提供できるようになりました。