英日双方向音声翻訳モデルのベンチマーク比較。Qwen3-ASR(1.7Bパラメータ、最高品質)とDistilled Whisper(756M、4倍高速)をOpenAI Whisper large-v3およびMeta SeamlessM4T v2と比較評価。

モデル(Hugging Face):

- voiceping-ai/qwen3-asr-ja-en-speech-translation — 英日双方向音声翻訳向けにファインチューニングしたQwen3-ASR(1.7Bパラメータ、評価において最高品質)

- voiceping-ai/whisper-ja-en-speech-translation — 英日双方向音声翻訳向けDistilled Whisper(756Mパラメータ、4倍高速)

推論コード(GitHub):

- qwen3-asr-ja-en-speech-translation — 推論スクリプト、評価パイプライン、モデル使用例

- whisper-ja-en-speech-translation — 推論スクリプト、評価パイプライン、モデル使用例

学習スクリプトはこれらのリポジトリには含まれていません。

概要

本研究では、英日双方向音声翻訳モデルを2つ紹介します。(1) Qwen3-ASR EN-JA(1.7Bパラメータ)はQwen3-ASR-1.7Bをベースに、約127万の翻訳ペアを用いた全パラメータSFTでファインチューニングし、EN→JAで4.2/5、JA→ENで4.0/5のスコアを達成。(2) Whisper EN-JA(756Mパラメータ)はWhisper large-v2をDistillしたモデルで、4層デコーダを持ち、212 tok/sを実現(Qwen3-ASRの4.6倍高速)。両モデルをFLEURSテストセットでOpenAI Whisper large-v3およびMeta SeamlessM4T v2 Largeと比較評価しました。品質はLLMジャッジ(Claude Opus 4.6)による5段階評価を採用。各リポジトリでの評価は独立して実施されており、テーブル間のスコアは直接比較できません。

開発の動機

英日間の音声翻訳において、開発者は2つのトレードオフに直面します。ビジネスコミュニケーションや安全性が重視される場面では高品質な翻訳が必要ですが、エッジデバイスでのリアルタイム対話には高速な翻訳が求められます。既存のモデルは英日双方向に対応していない場合(Whisper large-v3は日本語出力に非対応)や、オンデバイスでの展開には遅すぎる場合があります。

本研究では、この言語ペアに特化した速度と品質のトレードオフを定量化するため、品質重視のアーキテクチャ(Qwen3-ASR、1.7B)と速度重視のアーキテクチャ(Distilled Whisper、756M)の2つをファインチューニングし、既存のベースラインと比較評価します。これにより、デプロイメントの制約に応じた適切な選択が可能になります。

評価方法

両モデルはFLEURSテストサンプルを用いて、両方向の翻訳を評価しました。品質はLLMジャッジ(Claude Opus 4.6)による1〜5段階評価(正確性+流暢性)で測定。速度はNVIDIA RTX PRO 6000上でbfloat16を使用して計測。各リポジトリでの評価は独立して実施されており、テーブル間のスコアは直接比較できません。詳細な方法論は付録を参照してください。

結果

Qwen3-ASR評価(4モデル比較)

| モデル | パラメータ数 | EN→JA | JA→EN | 速度 (tok/s) |

|---|---|---|---|---|

| OpenAI Whisper large-v3 | 1.55B | N/A | 3.2/5 | 51.0 |

| Meta SeamlessM4T v2 Large | 1.50B | 3.8/5 | 3.0/5 | 48.6 |

| Whisper EN-JA Translation(本研究) | 756M | 2.6/5 | 2.4/5 | 212.1 |

| Qwen3-ASR EN-JA Translation(本研究) | 1.7B | 4.2/5 | 4.0/5 | 45.8 |

FLEURSテストサンプルによる品質評価(1〜5段階:正確性+流暢性)。速度はNVIDIA GPUでbfloat16を用いて計測。全スコアはQwen3-ASRリポジトリの評価に基づく。

Whisper EN-JA評価(3モデル比較)

| モデル | パラメータ数 | EN→JA | JA→EN | 速度 (tok/s) |

|---|---|---|---|---|

| OpenAI Whisper large-v3 | 1.55B | N/A | 3.6/5 | 51.0 |

| Meta SeamlessM4T v2 Large | 1.50B | 3.8/5 | 4.4/5 | 48.6 |

| Whisper EN-JA Translation(本研究) | 756M | 3.4/5 | 3.4/5 | 212.1 |

全スコアはWhisper EN-JAリポジトリの評価に基づく。評価サンプルとスコアリング方法が異なるため、上のテーブルのベースラインスコアとは異なります。

速度比較

| モデル | パラメータ数 | 速度 (tok/s) | 相対速度 |

|---|---|---|---|

| Qwen3-ASR EN-JA(本研究) | 1.7B | 45.8 | 1.0x |

| Meta SeamlessM4T v2 Large | 1.50B | 48.6 | 1.1x |

| OpenAI Whisper large-v3 | 1.55B | 51.0 | 1.1x |

| Whisper EN-JA(本研究) | 756M | 212.1 | 4.6x |

Distilled Whisperモデルは、パラメータ数が半分(756M vs 1.7B)でありながらQwen3-ASRの4.6倍のスループットを達成しており、低レイテンシが求められるデプロイメントに適しています。

モデルアーキテクチャ

- Qwen3-ASR EN-JA(1.7B) — 品質重視。Qwen3-ASR-1.7Bをベースに、約127万の英日翻訳ペアで全パラメータSFTを実施。オーディオエンコーダ+言語モデルのアーキテクチャ。

- Whisper EN-JA(756M) — 速度重視。Whisper large-v2をDistill:完全な32層エンコーダ(フリーズ)+4層デコーダ(32層から削減)により、パラメータ数半減で4.6倍高速な推論を実現。

学習ハイパーパラメータ、VRAM使用量、推論の詳細は以下の付録を参照してください。

翻訳例

FLEURSテストセットサンプルによる比較:

EN → JA

| ソース(EN音声) | SeamlessM4T v2 | Whisper EN-JA(本研究) | Qwen3-ASR EN-JA(本研究) |

|---|---|---|---|

| through the night between 150 and 200 copies were made now known as dunlap broadsides | 今ではダンラップ・ブロードサイズとして知られる 150 枚から 200 枚のコピーが作られました | 百五十から二百までのコピーが生成されました。 | 150から200本のコピーが作られました。これらは今では「Dunlap Broadside」として知られています。 |

| the find also grants insight into the evolution of feathers in birds | この発見は羽の進化と鳥の進化についても洞察を深めます | この発見は、鳥の羽の形にも影響を与えます。 | この発見は、羽や鳥の進化についても洞察を与えてくれます。 |

| many people don’t think about them as dinosaurs because they have feathers and can fly | 羽があって飛べるから 恐とは思わない人も多い | 多くの人々は、恐竜とは思わない。なぜなら、恐竜には羽があり、飛ぶことができるからです。 | (Qwen3評価セットに含まれず) |

JA → EN

| ソース(JA音声) | Whisper large-v3 | Whisper EN-JA(本研究) | Qwen3-ASR EN-JA(本研究) |

|---|---|---|---|

| 残念ながら 運転手の行動を100%の確率で予測することはできないので 交通の流れを研究することは困難です | Unfortunately, it is difficult to predict the behavior of the driver with 100% probability, so it is difficult to study the flow of traffic. | Unfortunately, it’s impossible to predict the behavior of drivers with 100% certainty. Therefore, it’s difficult to study the flow of traffic. | Unfortunately, it’s not possible to predict the actions of drivers with 100% certainty. Therefore, it’s difficult to study the flow of traffic. |

| 夜空の下でピラミッドに映像が浮かび ピラミッドが次々とライトアップされます | The image of the pyramid is reflected under the night sky, and the pyramid is lighted up one after another. | The pyramid is lit up one after another. | Under the night sky, images of pyramids are illuminated. The pyramids are lit up one after another. |

| キルヒネル夫人は アルゼンチン劇場で大統領選に出馬するという意向を表明しました | Mrs. Kirchner expressed her intention to appear in the presidential election at the Argentine theater. | Kylhine announced her intention to run for president in the Argentina theater. | Mrs. Kirchner announced her intention to run for president at the Alzen Theatre. |

上記の例から、Qwen3-ASRはより完全で文脈に即した翻訳を生成しており、特にEN→JAでは固有名詞や文構造が保持されています。Whisper EN-JAは詳細を省略する傾向がありますが、流暢性は維持されています。なお、EN→JAの1サンプルはQwen3の評価セットに含まれていないため、比較は部分的です。

制約事項

- LLMによる品質評価: スコアはClaude Opus 4.6によるもので、人間の評価者によるものではありません。LLMジャッジには、人間の翻訳品質評価とは異なる体系的なバイアスが存在する可能性があります。

- 評価の独立実施: 2つのリポジトリはFLEURSの異なるサブセットと異なるスコアリングを使用しているため、ベースラインスコア(SeamlessM4Tなど)はテーブル間で異なり、直接比較はできません。

- 単一言語ペア: 結果は英日のみに適用され、他の言語ペアへの一般化は保証されません。

- GPU環境での速度: 速度はNVIDIA GPU上でbfloat16を用いて計測。モバイルCPU/NPUでのオンデバイス性能は大幅に異なります。

今後の研究

- より小型の品質重視モデル: より小さなQwen3-ASRバリアント(例:Qwen3-ASR-0.6B)や将来の1B未満バリアント(0.8Bリリースなど)を評価し、1.7Bとの品質/速度/メモリのトレードオフを定量化。

- 統一評価分割: すべてのモデルを1つの固定FLEURSサブセットと1つのスコアリングパイプラインで再評価し、品質スコアを直接比較可能に。

- 人間による評価プロトコル: バイリンガルの人間評価者と評価者間一致度の報告を追加し、LLMジャッジの結果を検証。

- 同時翻訳のレイテンシ: tok/sだけでなく、リアルタイム使用のためのストリーミング/同時翻訳指標を用いた翻訳遅延の測定。

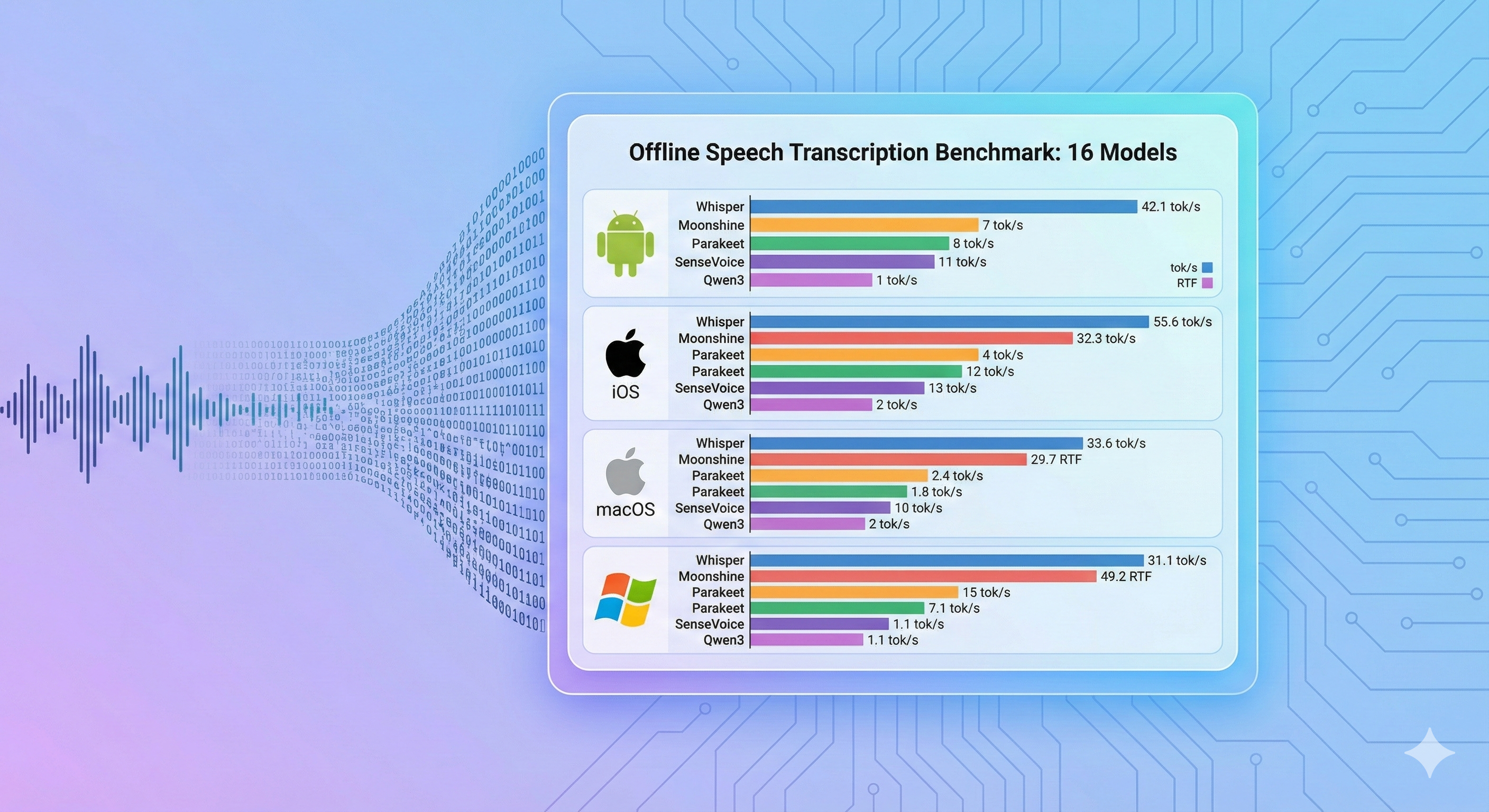

- オンデバイスデプロイメントのベンチマーク: Android/iOS NPUおよびCPU上で同様の比較を実施(メモリおよびエネルギー消費を含む)。

結論

英日間の音声翻訳は、2つの異なるトレードオフで実現可能です:

速度重視:Whisper EN-JA(756M) は、リアルタイムアプリケーションに適した実用的な選択肢です。212 tok/sの処理速度を実現し、比較対象モデルの半分のパラメータ数でQwen3-ASRの4.6倍のスループットを達成します。

精度重視:Qwen3-ASR EN-JA(1.7B) は、翻訳品質を優先する場合のより良い選択肢です。独自の評価でEN→JA: 4.2/5、JA→EN: 4.0/5のスコアを達成しています。

既存のベースラインモデルはどちらも双方向を十分にカバーしていません。Whisper large-v3はEN→JAの翻訳に非対応(英語のみ出力)であり、当社の両モデルは単一モデルでバランスの取れた双方向翻訳を提供します。

品質スコアは各モデル独自の評価(LLMジャッジとしてClaude Opus 4.6を使用)に基づいており、2つのリポジトリはFLEURSの異なるサンプルと異なるスコアリングを使用しているため、テーブル間のベースラインスコアは直接比較できません。デプロイメントの判断には、上記の翻訳例セクションが実際の出力品質のより具体的な比較を提供します。

付録:学習・評価・ハードウェアの詳細

GPU / VRAM

GPU: NVIDIA RTX PRO 6000 Blackwell Max-Q(98 GB)、bfloat16

| モデル | パラメータ数 | ピークVRAM | 速度 (tok/s) |

|---|---|---|---|

| Whisper EN-JA(本研究) | 756M | 1.56 GB | 212.1 |

| SeamlessM4T v2 Large | 1.50B | 2.89 GB | 48.6 |

| OpenAI Whisper large-v3 | 1.55B | 3.13 GB | 51.0 |

| Qwen3-ASR EN-JA(本研究) | 1.7B | ~4 GB* | 45.8 |

* Qwen3-ASRのVRAM計測は保留中(CPUでも動作可能)。

Qwen3-ASR EN-JA(1.7B) — 学習設定

| パラメータ | 値 |

|---|---|

| ベースモデル | Qwen3-ASR-1.7B |

| ファインチューニング手法 | 全パラメータSFT |

| 学習データ | 約127万の音声-テキスト翻訳ペア(EN↔JA) |

| オプティマイザ | AdamW |

| 学習率 | 1e-5 |

| 学習率スケジューラ | Cosine with warmup(ウォームアップ3%) |

| 実効バッチサイズ | 64(バッチ8 × 勾配累積8) |

| 学習エポック数 | 約1.3 |

| 最良チェックポイント | エポック1.16(評価損失基準) |

| 精度 | bfloat16 |

| 最大音声長 | 30秒 |

翻訳方向はlanguageパラメータ(ターゲット出力言語)で制御:

language="Japanese"→ EN音声 → JAテキストlanguage="English"→ JA音声 → ENテキスト

Whisper EN-JA(756M) — 学習設定

| パラメータ | 値 |

|---|---|

| ベースアーキテクチャ | Whisper large-v2(Distilled) |

| エンコーダ層数 | 32(全層、学習中フリーズ) |

| デコーダ層数 | 4(32層から削減) |

| 隠れ層サイズ | 1280 |

| 総パラメータ数 | 約756M |

| オプティマイザ | AdamW |

| 学習率 | 2e-4 |

| 学習率スケジューラ | Cosine with restarts |

| バッチサイズ | 72 |

| 学習エポック数 | 20 |

| ラベルスムージング | 0.1 |

| エンコーダ | フリーズ(事前学習済み表現を保持) |

| 勾配チェックポイント | 有効 |

| 最大音声長 | 30秒 |

翻訳方向はforced_decoder_ids(ソース音声言語)で制御:

language="en"+task="translate"→ EN音声 → JAテキストlanguage="ja"+task="translate"→ JA音声 → ENテキスト

評価方法

| パラメータ | 値 |

|---|---|

| データセット | FLEURSテストセット(両翻訳方向) |

| 品質評価 | 1〜5段階(正確性+流暢性)、LLMジャッジ(Claude Opus 4.6) |

| 速度 | NVIDIA GPU上でbfloat16を用いたトークン/秒 |

| 評価の実施 | リポジトリごとに独立 — FLEURSサブセットが異なり、リポジトリ間のスコアは直接比較不可 |

テキスト正規化:

- 英語: BasicTextNormalizer(小文字化、句読点除去)

- 日本語: 形態素解析と漢字表示形の正規化

推論速度まとめ

| モデル | パラメータ数 | 速度 (tok/s) | 相対速度 |

|---|---|---|---|

| Qwen3-ASR EN-JA(本研究) | 1.7B | 45.8 | 1.0x |

| Meta SeamlessM4T v2 Large | 1.50B | 48.6 | 1.1x |

| OpenAI Whisper large-v3 | 1.55B | 51.0 | 1.1x |

| Whisper EN-JA(本研究) | 756M | 212.1 | 4.6x |

Qwen3-ASRの推論はCPU上で実行(GPUにも対応)。Whisper EN-JAの推論はCPUまたはGPU上で実行。

参考文献

当社のモデル:

- Qwen3-ASR EN-JA Translation — 1.7Bパラメータ(Apache 2.0)

- Whisper EN-JA Translation — 756Mパラメータ、4倍高速(Apache 2.0)

ベースモデル:

- Qwen3-ASR-1.7B — Qwen3自動音声認識モデル

- OpenAI Whisper large-v3 — 大規模音声認識・翻訳モデル

- Meta SeamlessM4T v2 Large — 大規模多言語音声翻訳モデル

評価データセット:

- FLEURS — Few-shot Learning Evaluation of Universal Representations of Speech